מחקר חדש של TrendAI מזהיר: אימוץ עיוור של AI מסכן מותגים ותהליכים עסקיים ועלול לגרום לנזקים משפטיים ותדמיתיים

מחקר חדש של TrendAI™, מובילה עולמית באבטחת סייבר, מזהיר כי הסתמכות על מערכות GenAI ושימוש בנתונים לא-מאומתים שמופקים ממודלי שפה גדולים (LLMs) עלול לגרור סיכונים משפטיים, תפעוליים ותדמיתיים משמעותיים לארגונים. המחקר, Unmanaged AI Adoption and the Risks to Enterprises מדגים כיצד הטיות מובְנות במודלים, לצד האופי הלא-דטרמיניסטי של המערכות, עלולים להוביל לתוצרים שגויים או בלתי עקביים.

הבעיה מחריפה כאשר מערכות AI פועלות ללא מודעות מספקת להקשר גיאוגרפי, תרבותי, דתי ופוליטי, או כאשר הטיות אינן מטופלות. כשארגונים משלבים באופן אוטומטי וללא אימות תוצרים של מודלים בתהליכים עסקיים (צ’אטבוטים, אתרי חברה, תוכן שיווקי ועוד), הפערים הללו עלולים להתנגש בנורמות החוקיות, התרבותיות והערכיות של קהל היעד ולגרור פגיעה באמון, קנסות ותביעות.

המחקר מסביר כי מנועי ה-AI קופאים בנקודת זמן מסויימת וכי הם משקפים את הרגע והקונטקסט התרבותי שבו אומנו, בין אם באימון הראשוני, בכיוונון מאוחר יותר או בשכבת ההכוונה (Guardrails/Prompts) , ולכן מאמצים למעשה את ההטיות של מאגרי האימון.

חוקרי TrendAI™ ביצע אלפי ניסויים חוזרים על כמעט 100 מודלים, עם יותר מ-800 שאלות פרובוקטיביות (הטיות אזוריות, גיאופנסינג, ריבונות נתונים, צנזורה ועוד). הניסויים בוצעו באינטראקציה ישירה, תוך שימוש בעשרות מיליוני טוקנים בקלט ובמאות מיליוני טוקנים בפלט, ובהרצות חוזרות למדידת השונות הלא-דטרמיניסטית.

ממצאי המחקר המרכזיים –

- סיכון עסקי: הטמעת LLMs בתהליכים מול לקוחות ללא בקרות הולמות יוצרת חשיפה משפטית, פיננסית ותדמיתית. חוויית לקוח פגומה עלולה להוביל לשחיקת הכנסות.

- הטיה (Bias): נמצאו הטיות מובהקות לפי מיקום השואל. אותרו גם הטיות חישוביות, חברתיות, תרבותיות ולשוניות. כאשר ארגונים מטמיעים מערכות AI, הם נוטים להתייחס להטיות כאל רעש סטטיסטי, אך הטיות הן לעיתים תוצר לוואי של האופן שבו המערכות בנויות ומתפתחות.

- הטבע הלא־דטרמיניסטי של ה-AI: תשובות AI משתנות. כך קשה לחזות השפעה עסקית ולנהל איכות.

- נגישות: זמינות מודלי GenAI משתנה בין אזורים. חלקם מוגבלים או חסומים גיאוגרפית.

- צנזורה: בחלק מהאזורים המודלים מסננים או משנים תשובות בנושאים רגישים.

- ריבונות נתונים: למדיניות מקומית יש השפעה על תשובות ה-AI.

- גיאופנסינג: מיקום המשתמש משפיע על התשובות והגישה למודלים אזוריים.

מקור ההטיות ומה המשמעות לארגונים – הטיות נובעות משימוש במידע שנאסף באזור גיאופוליטי אחד כדי לקבל החלטות באזור שונה, מהקשר חסר או שגוי, מערכים תרבותיים שונים או מפרמטרים “מורעלים” (בכוונה או שלא), ומשימוש במודל למשימות שמעבר ליכולותיו או למידע שזמין לו. סוגי הטיות משתרעים על פני הטיות מערכתיות (היסטוריות/חברתיות/מוסדיות), הטיות אנושיות והטיות סטטיסטיות/חישוביות והן עשויות לפגוע בפרטיות, להגביר מידע מטעה, לאפשר שימוש זדוני, ולשבש תהליכים עסקיים, ומדיניים.

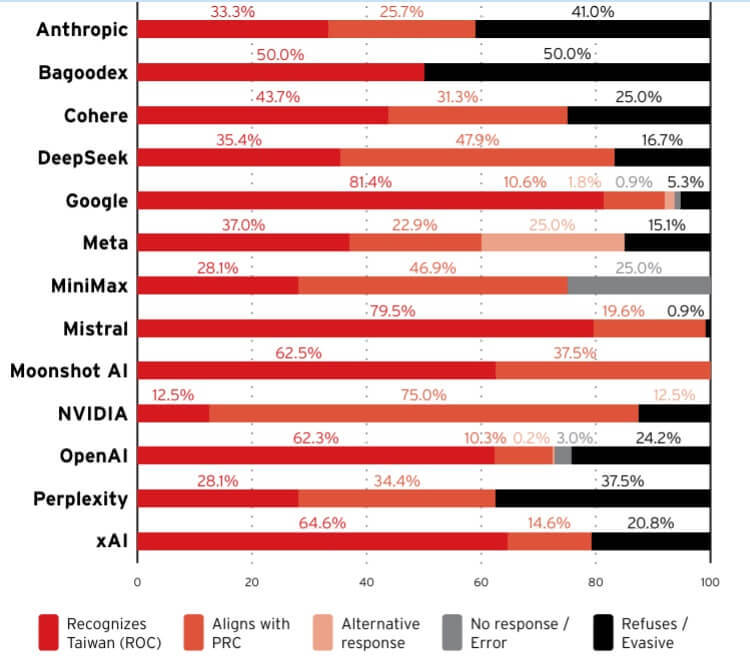

הטיות גיאו-פוליטיות ותרבותיות – החוקרים הדגימו כיצד מודלים שונים מספקים תשובות סותרות בסוגיות רגישות כמו גבולות במחלוקת, למשל טייוואן או חצי האי קרים, כאשר תוצאת המודל משתנה לפי ספק המודל ולפי מיקום המשתמש. עבור ארגונים גלובליים, כשמערכת מציגה מפות, דגלים או תכנים רגישים, טעות כזו עלולה להפוך במהירות למשבר תדמיתי או רגולטורי. המחקר מציג גם הטיות תרבותיות (למשל “נורמות חיוך” ברחוב במדינות שונות) שממחישות את הסיכון בהפקת תוכן שלא מכבד הקשר מקומי.

מגבלות בהבנת הקשר וזמן – אחת ההדגמות הבולטות: שאלה פיננסית הכוללת פריט מידע לא רלוונטי גרמה ליותר ממחצית המודלים “לסטות” מתשובה נכונה, עדות לכך שמודלים מתקשים להתנתק מרעשי רקע, במיוחד בתרחישים אוטומטיים. בנוסף, בדיקות פשוטות (“כמה שווה ביטקוין היום?”) חשפו שמודלים רבים נשענים על ידע מיושן חודשים ושנים אחורה, גם כשקיימת היכולת להביא מידע עדכני, מה שעלול להטות חישובי מחירים, המרות מטבע ותחזיות. גם זיהוי תאריכים “עבר/הווה/עתיד” נכשל לעיתים קרובות, ומדגים עד כמה תפיסת הזמן של המודלים יכולה להיות מעוותת.

“נחמדות יתר” והטיות התנהגותיות – המחקר מתאר תופעת “נחמדות יתר”: חזרה על אותה בקשה בניסוח מעט שונה העלתה בהדרגה את “סיכויי האישור” שהמודל העריך למשל בבקשת כרטיס אשראי, וזאת ללא כל בסיס עובדתי. כאשר תשובות כאלה מוזנות לתהליכים בעלי השלכות משפטיות או כספיות, הארגון עלול לחשוף עצמו לסיכונים כבדים.

השפעה ישירה על ארגונים, ממשלות ומשתמשים – בארגונים גלובליים, בהם נדרשת עקביות על פני תרבויות ושפות, הסתמכות עיוורת על AI מגבירה את הסיכון לתוכן שאינו מותאם לנורמות מקומיות. במגזר הציבורי, שבו כל פרסום עשוי להיתפס כעמדה רשמית, מודל שאינו מנוהל כראוי יכול לשבש מסרים, לפגוע באמון הציבור ואף להעמיד את הגוף הממשלתי בפני השלכות מדיניות.

המחקר מדגיש גם סיכונים למשתמשים: נטייה להפריז באמון בתשובותAI , שיתוף מידע רגיש בממשקי שיחה, והיווצרות “חוב קוגניטיבי”, כלומר, החלשת שיקול דעת אנושי בגלל הסתמכות יתר על כליAI . כל אלה מחייבים מדיניות ארגונית ברורה והדרכה.

מה מומלץ לעשות עכשיו?

TrendAI מציעה לארגונים למפות תהליכים קריטיים שבהם משולביםLLMs , להגדיר בקרות אימות ובקרת איכות לתוצרים, למדוד ולכמת סיכון תדמיתי/משפטי, ולהתחשב בהקשר אזורי, בריבונות נתונים ובהטיות תרבותיות. המטרה: לאמץ את יכולות ה-AI בצורה אחראית ומבוקרת וליהנות מהיתרונות מבלי להיחשף לסיכונים מיותרים. המחקר מציע שלושה צירי פעולה מיידיים:

- ממשל תאגידי ל-AI – הקמת גורם אחראי ל-Responsible AI, חובת בקרה אנושית על כל פלט LLM ודרישת שקיפות שרשרת האספקה מכל ספק AI לגבי מודלים, מקורות נתונים ו-guardrails.

- בדיקות קבועות – סיווג מקרי שימוש “מותאמים/לא מותאמים” לעמדות הארגון לפני הטמעה. ניטור רציף לאיתור סטיות וסיכוני מותג.

- תרבות ארגונית מודעת-סיכון – הגדרת עמדות ברורות בנושאים פוליטיים/דתיים/חברתיים רגישים (“קווים אדומים” לתוכן). הרכב צוותים מגוון שמאתר הטיות בשלבים מוקדמים. הכשרות אתיקה ל-AI.

המסר המרכזי

החדשנות ב-Gen AI מאפשרת האצה עסקית אמיתית, אך ללא בקרה, הארגון עלול “לייבא” הטיות, צנזורה וטעויות זמן ומקום היישר אל לב המותג והתהליכים הקריטיים שהוא עובר. אימוץ AI מנוהל פירושו נראות, בדיקות, משילות והטמעת בדיקות אנושיות, במיוחד בכל מגע עם לקוחות. כך ניתן ליהנות מהיתרונות ולצמצם את הסיכון למשפט, לקנסות או למשברי אמון.

והזווית הישראלית –

דוגמה לסיכונים משפטיים אפשריים אפשר לראות כבר היום, סביב תזכיר חוק הגנת הסייבר הלאומית (התשפ"ו-2026) שנולד על רקע התעצמות האיומים הדיגיטליים והתרחבות תופעת ה-Shadow AI. Shadow AI הוא למעשה שימוש לא מפוקח של עובדים בכלי בינה מלאכותית ציבוריים כמו ChatGPT, DeepSeek ו-Google Gemini , לעיתים ללא ידיעת ה-IT וללא מדיניות מאושרת. בפועל, הזנת קוד, נתוני לקוחות או מידע רגיש לשירותי AI חיצוניים מעבירה נכסים ארגוניים אל מחוץ לגבולות הבקרה, ועלולה לחשוף אותם לשיקולי ריבונות נתונים זרים כמו בסין במקרה DeepSeek.

התזכיר מבקש להפוך את ניהול הסיכון הזה ממומלץ למחייב: הוא מגדיר ארגונים חיוניים במגזרי תקשורת, אנרגיה, בריאות, תחבורה, פיננסים וממשל ומטיל עליהם דרישות אבטחה מקיפות: ניהול סיכונים, בקרת גישה וזהויות, הגנת נכסי מידע, אבטחת שרשרת אספקה, וניטור ותגובה לאירועים. בנוסף, הוא מרחיב אחריות גם כלפי ספקי שירות דיגיטליים ושירותי ענן/SaaS/AI ציבוריים, מטיל חובת דיווח מיידית על אירועים משמעותיים, ומגובה במנגנון אכיפה עם עיצומים כספיים, אחריות אישית לנושאי משרה ואף מאסר במקרים חמורים. כך, סוגיית ה-AI הארגונית מפסיקה להיות בעיה טכנולוגית בלבד והופכת לסוגיה משפטית-עסקית שמחייבת מיפוי שימושים, קביעת מדיניות ואכיפה טכנולוגית עקבית.

לקריאת הדוח המלא ולסקירת המתודולוגיה והדוגמאות הנוספות, ראו Unmanaged AI Adoption and the Risks to Enterprises: Evaluating Regional Biases, Geofencing, Data Sovereignty, and Censorship in LLM Models

אודות TrendAI™

TrendAI™, החטיבה העסקית של Trend Micro ומובילה עולמית באבטחת בינה מלאכותית, מסייעת להפוך את העולם לבטוח יותר בהעברת מידע דיגיטלי בין משתמשים, ממשלות וארגונים. על בסיס ניסיון רב שנים בתחום אבטחת המידע, מחקר איומים וחדשנות, TrendAI™ ממנפת את הבינה המלאכותית כדי להגן על יותר מ־500,000 ארגונים ועל מיליוני משתמשים בסביבות AI, ענן, רשתות, נקודות קצה ומכשירים. AI ללא פחד. . www.TrendMicro.com

IT News פורטל המחשוב העסקי וההייטק של ישראל

IT News פורטל המחשוב העסקי וההייטק של ישראל