* Falcon Mamba 7B הוא מודל השפה במרחב המצב (SSLM) ממקור פתוח המדורג במקום הראשון בעולם מבחינת ביצועיו, כפי שאומת באופן בלתי תלוי על ידי Hugging Face.

*ל-SSLMs יש עלות זיכרון נמוכה והם אינם דורשים זיכרון נוסף על מנת ליצור בלוקים שרירותיים ארוכים של טקסט

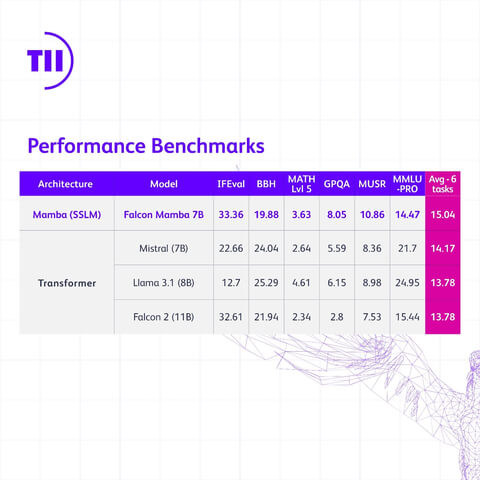

*הביצועים של Falcon Mamba 7B אף עולים על אלה של מודלים מסורתיים של ארכיטקטורת טרנספורמר, כגון Llama 3.1 8B של Meta ו-7B של Mistral

*מודל חדש משקף את החדשנות והגישה החלוצית של אבו דאבי במחקר ובפיתוח של בינה מלאכותית

אבו דאבי, איחוד האמירויות הערביות, 12 באוגוסט 2024, (BUSINESS WIRE):

המכון לחדשנות טכנולוגית Technology Innovation Institute (TII), מרכז מחקר מדעי גלובלי מוביל ועמוד התווך במחקר היישומי של מועצת המחקר הטכנולוגי של אבו דאבי (ATRC), הציג מודל שפה גדול חדש מסדרת Falcon, Falcon Mamba 7B. המודל החדש הוא מודל השפה במרחב המצב (SSLM) ממקור פתוח המדורג במקום הראשון בעולם מבחינת ביצועיו, כפי שאומת באופן בלתי תלוי על ידי Hugging Face.

כ-SSLM הראשון עבור Falcon, הוא שונה ממודלים הקודמים של Falcon, המשתמשים כולם בארכיטקטורה המבוססת על טרנספורמר. מודל Falcon Mamba 7B החדש מהווה דוגמה נוספת למחקר החלוצי המתבצע על ידי המוסד ולכלים ולמוצרים פורצי הדרך שהוא מעמיד לרשות הקהילה בפורמט של מקור פתוח.

פייסל אל-באנאי, המזכיר הכללי של ATRC ויועץ לנשיא האיחוד האמירויות לענייני מחקר אסטרטגי וטכנולוגיה מתקדמת, אמר: "Falcon Mamba 7B הוא מודל הבינה המלאכותית הרביעי ברציפות של TII המדורג במקום הראשון ומחזק את מעמדה של אבו דאבי כמרכז גלובלי למחקר ופיתוח של בינה מלאכותית. הישג זה מדגיש את המחויבות הבלתי מתפשרת של איחוד האמירויות לחדשנות".

עבור מודלים של ארכיטקטורת טרנספורמר, הביצועים של Falcon Mamba 7B עולים על אלה של Llama 3.1 8B ו-Llama 3 8B של Meta, ו-7B של Mistral על פי אמות המידה החדשות שנקבעו על ידי HuggingFace. בינתיים, בכל הקשור ל-SSLMs האחרים, Falcon Mamba 7B מתעלה על כל המודלים ממקור פתוח לפי אמות המידה הישנות ויהיה המודל הראשון בלוח התוצאות החדש של HuggingFace, המבוסס על אמות מידה מחמירות יותר.

ד"ר נג'וואה אאראג', המנהלת הכללית של TII, אמרה: "המכון לחדשנות טכנולוגית ממשיך למתוח את הגבולות של הטכנולוגיה עם המודלים של הבינה המלאכותית מסדרת Falcon. Falcon Mamba 7B מהווה דוגמה לעבודה חלוצית באמת וסולל את הדרך להמצאות עתידות בתחום הבינה המלאכותית אשר יחזקו את היכולות האנושיות וישפרו את החיים".

מודלים של מרחב מצב מצטיינים במיוחד בהבנה של מצבים מורכבים המתפתחים עם הזמן, כגון ספר שלם. זאת מכיוון ש-SSLMs אינם דורשים תוספת של זיכרון כדי לעכל כמויות גדולות של מידע.

לעומת זאת, מודלים המבוססים על טרנספורמר יעילים מאד בזכירה ובשימוש במידע שעובד על ידם בשלב מוקדם יותר ברצף. עובדה זו הופכת אותם לטובים מאד במטלות כגון יצירת תוכן, אולם מכיוון שהם משווים כל מילה עם כל מילה אחרת, הדבר דורש עוצמה חישובית משמעותית.

ל-SSLMs יכולים להימצא שימושים בתחומים שונים כגון משימות של אומדנים, תחזיות ובקרה. בדומה למודלים של ארכיטקטורת טרנספורמר, הם מצטיינים גם במטלות של עיבוד שפה טבעית וניתן להשתמש בהם עבור תרגום מכונה, סיכום טקסט, ראייה ממוחשבת ועיבוד קול.

ד"ר חכים חאסיד, החוקר הראשי בפועל של יחידת AI Cross-Center ב-TII, אמר: "כאשר אנו מציגים את Falcon Mamba 7B, אני גאה באקוסיסטם השיתופי של TII אשר טיפח את הפיתוח שלו. גרסה זו מהווה צעד משמעותי קדימה, המעניק השראה לנקודות מבט רעננות ומניע עוד יותר את מסע החיפוש אחר מערכות חכמות. אנו ב-TII מותחים את הגבולות של SSLM ומודלים של טרנספורמר כדי להצית חדשנות נוספת בתחום הבינה המלאכותית היוצרת.

מודלי השפה הגדולים של Falcon רשמו יותר מ-45 מיליון הורדות, נתון המוכיח את ההצלחה יוצאת הדופן של המודלים. Falcon Mamba 7B ישוחרר תחת TII Falcon License 2.0, רישיון התוכנה המתירני המבוסס על Apache 2.0 וכולל מדיניות שימוש מקובל המקדמת את השימוש האחראי בבינה מלאכותית. ניתן למצוא מידע נוסף על המודל החדש בכתובת FalconLLM.TII.ae.

IT News פורטל המחשוב העסקי וההייטק של ישראל

IT News פורטל המחשוב העסקי וההייטק של ישראל